Halo para pengunjung blog atau pencari materi hehe, selamat datang kembali di blog saya yang sederhana ini. Pada kesempatan kali ini saya ingin membahas tentang Konsep Pengukuran dan Esensi Analisis sebuah Website, sebelum saya membahas lebih dalam mengenai pembahasan tersebut sebaiknya kita mengetahui apa si website itu? Website adalah kumpulan halaman yang menampilkan informasi data teks, data gambar, data animasi, suara, video atan gabungan dari semuanya. Website juga dapat dimiliki dengan dua cara yaitu membeli website yang telah dibuat, atau membuat dan mendesignnya sendiri walaupun terlihat susah. Nah, setelah mengetahui pengertian website, maka kita dapat melanjutkan ke pembahasan Konsep Pengukuran dan Esensi Analisis Web.

- Konsep Kualitas Pengukuran Web

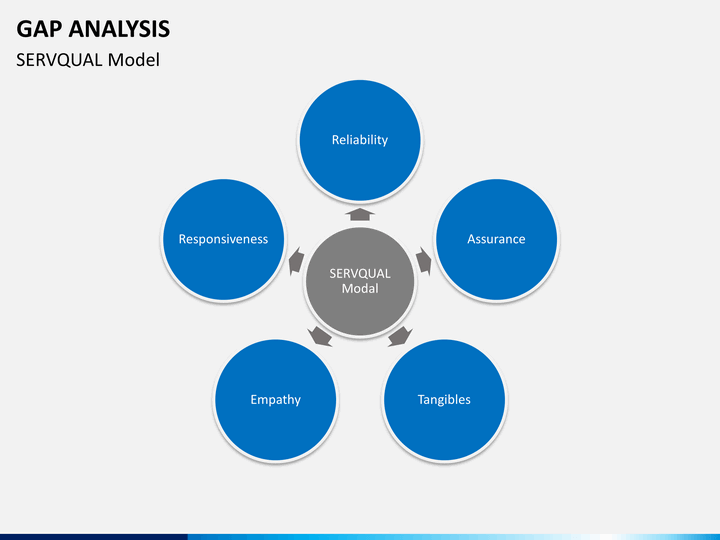

ServQual adalah salah satu metode untuk mengukur tingkat kepuasan pelanggan terhadap layanan yang diberikan. Metode ServQual memperhatikan harapan pelanggan mengenai layanan yang akan diterimanya (expectation) dan layanan yang telah diterimanya (perception). Menurut Tjiptono (2005) service quality adalah suatu tingkat keunggulan yang diharapkan dimana pengendalian atas tingkat keunggulan tersebut bertujuan untuk memenuhi kebutuhan pelanggan. Berikut ini adalah dimensi-dimensi dari ServQual :

• Reliability : kemampuan untuk memberikan jasa dengan segera dan memuaskan.

• Responsiveness : kemampuan untuk memberikan jasa dengan tanggap.

• Assurance : kemampuan, kesopanan, dan sifat dapat dipercaya yang dimiliki oleh para staf, bebas dari bahaya, resiko dan keragu-raguan.

• Emphaty : kemudahan dalam melakukan hubungan komunikasi yang baik dan memahami kebutuhan pelanggan.

• Tangibles : fasilitas fisik, perlengkapan, pegawai dan sarana komunikasi.

WebQual merupakan salah satu metode pengukuran kualitas website yang dikembangkan oleh Stuart Barnes dan Richard Vidgen (1998) berdasarkan persepsi pengguna akhir (end-user), WebQual adalah “structured and disciplined process that provide a means to identify and carry the voice of the customer through each stage of product and or service development and implementation” yang artinya WebQual adalah proses terstruktur dan disiplin yang menyediakan sarana untuk mengidentifikasi dan membawa suara pelanggan melalui setiap tahap pengembangan produk dan atau jasa dan pelaksanaanya.

Berikut ini adalah dimensi-dimensi dari WebQual :

• Usability Quality : Persepsi pengguna terhadap kemudahan dibaca dan dipahami, serta kemudahan beroperasi dan bernavigasi,

• Information Quality : Persepsi pengguna terhadap informasi yang disediakan sesuai dengan kebutuhan dan tujuan, selalu up-to-date dan akurat, serta informasi yang dapat dipercaya, relevan, mudah dibaca, dan dipahami,

•

Service Interaction Quality : Persepsi pengguna terhadap semua proses layanan dapat diselesaikan secara online, proyeksi gambar sesuai dengan situs pemerintah, serta penggunaan situs sebagai sarana interaksi alternatif yang keamanannya lebih baik.

WebQual merupakan metode pengukuran kualitas Website berdasarkan persepsi pengguna akhir. WebQual sudah mulai dikembangkan sejak tahun 1998 dan telah mengalami beberapa interaksi dalam penyusunan dimensi dan butir pertanyaannya dengan metodologi Quality Function Deployment (QFD) yang merupakan sebuah sarana untuk mengidentifikasi dan membawa suara pelanggan melalui setiap tahap pengembangan produk dan juga jasa.

Kualitas penggunaan meliputi, kemudahan untuk dipelajari, kemudahan untuk dimengerti situs dalam pemberian informasi yang diharapkan pengguna, kemudahan untuk ditelusuri dalam pencarian informasi, kemudahan dalam pengoperasian situs bagi pengguna, kemudahan dalam sistem navigasi memberikan pengalaman baru tentang informasi yang dibutuhkan pengguna, WebQual menggunakan tiga parameter, yaitu :

• Kualitas informasi dari penelitian sistem informasi,

• Interaksi dan kualitas layanan dari penelitian kualitas sistem informasi, e-commerce, dan pemasaran,

• Usability dari human-computer interaction.

2. Esensi Analisis Web

Analisis web adalah pengukuran, pengumpulan, analisis, dan pelaporan data web untuk tujuan memahami dan mengoptimalkan penggunaan web. Namun, analisis Web bukan hanya proses untuk mengukur lalu lintas web tetapi dapat digunakan sebagai alat untuk penelitian bisnis dan pasar, dan untuk menilai dan meningkatkan efektivitas situs web. Aplikasi analisis Web juga dapat membantu perusahaan mengukur hasil kampanye iklan cetak atau siaran tradisional. Ini membantu seseorang untuk memperkirakan bagaimana lalu lintas ke situs web berubah setelah peluncuran iklan baru. Analisis Web menyediakan informasi tentang jumlah pengunjung ke situs web dan jumlah tampilan halaman. Ini membantu mengukur tren lalu lintas dan popularitas yang berguna untuk riset pasar.

Proses analisis web terdiri dari empat tahap, yaitu :

1. Collection of data (Pengumpulan Data)

Tahap ini adalah pengumpulan data dasar dan dasar. Biasanya, data ini adalah hitungan hal. Tujuan dari tahap ini adalah untuk mengumpulkan data.

2. Processing of data into information (Pemrosesan data menjadi informasi)

Tahap ini biasanya menghitung dan menjadikannya rasio, meskipun mungkin masih ada beberapa penghitungan. Tujuan dari tahap ini adalah untuk mengambil data dan menyesuaikannya menjadi informasi, khususnya metrik.

3. Developing KPI (Mengembangkan KPI)

Tahap ini berfokus pada penggunaan rasio (dan jumlah) dan menanamkannya dengan strategi bisnis, disebut sebagai indikator kinerja utama (KPI). Sering kali, KPI menangani aspek konversi, tetapi tidak selalu. Itu tergantung pada organisasi.

4. Formulating online strategy (Merumuskan strategi online)

Tahap ini berkaitan dengan tujuan, sasaran, dan standar online untuk organisasi atau bisnis. Strategi-strategi ini biasanya terkait dengan menghasilkan uang, menyimpan uang, atau meningkatkan pangsa pasar.

Adapun Tujuan mendasar dari analisis web adalah untuk mengumpulkan dan menganalisis data yang terkait dengan lalu lintas web dan pola penggunaan. Data terutama berasal dari empat sumber:

• Data permintaan HTTP langsung : langsung berasal dari pesan permintaan HTTP (header permintaan HTTP).

• Tingkat jaringan dan server menghasilkan data yang terkait dengan permintaan HTTP : bukan bagian dari permintaan HTTP, tetapi diperlukan untuk transmisi permintaan yang berhasil – misalnya, alamat IP pemohon.

• Data tingkat aplikasi yang dikirim dengan permintaan HTTP : dihasilkan dan diproses oleh program tingkat aplikasi (seperti JavaScript, PHP, dan ASP.Net), termasuk sesi dan rujukan. Ini biasanya ditangkap oleh log internal daripada layanan analisis web servis.

• Data eksternal : dapat digabungkan dengan data di tempat untuk membantu menambah data perilaku situs web yang dijelaskan di atas dan menginterpretasikan penggunaan web. Misalnya, alamat IP biasanya dikaitkan dengan wilayah Geografis dan penyedia layanan internet, buka email dan klik-tayang, data kampanye surat langsung, penjualan dan riwayat timah, atau tipe data lain yang diperlukan.

Analisis web memiliki keunggulan signifikan sebagai pendekatan metodologis untuk penelitian dan investigasi

Perilaku Faktor-faktor ini termasuk:

• Skala : Aplikasi log transaksi dapat mengumpulkan data hingga tingkat yang mengatasi masalah kritis faktor pembatas dalam studi pengguna laboratorium. Studi pengguna di laboratorium biasanya dibatasi dalam hal ukuran sampel, lokasi, ruang lingkup, dan durasi.

• Daya : Ukuran sampel data log transaksi bisa sangat besar, sehingga pengujian inferensi dapat sorot hubungan yang signifikan secara statistik. Menariknya, terkadang jumlah datanya log transaksi dari Web sangat besar sehingga hampir setiap hubungan berkorelasi secara signifikan. Karena kekuatan yang besar, para peneliti harus memperhitungkan efek ukuran.

• Cakupan : Karena data log transaksi dikumpulkan dalam konteks alami, peneliti dapat menyelidiki seluruh rentang interaksi pengguna-sistem atau fungsionalitas sistem dalam multi-variabel konteks.

• Lokasi : Data log transaksi dapat dikumpulkan di lingkungan yang naturalistik dan terdistribusi. Oleh karena itu, pengguna tidak harus berada dalam pengaturan laboratorium buatan.

• Durasi : Karena tidak perlu merekrut peserta tertentu untuk studi pengguna, transaksi data log dapat dikumpulkan selama periode yang diperpanjang.

Daftar Pustaka :

- https://en.m.wikipedia.org/wiki/Web_analytics

- https://think360studio.com/process

- Jansen, B. J. (2009). Understanding user-web interactions via web analytics. Synthesis Lectures on Information Concepts, Retrieval, and Services, 1(1), 1-102.